El uso masivo de conjuntos de datos sintéticos, no reales y más baratos, para entrenar la inteligencia artificial genera un fenómeno inesperado que estropea los resultados

El peor enemigo de la inteligencia artificial podría ser la propia inteligencia artificial. Un estudio publicado en julio de 2023 por investigadores de las universidades de Rice y Stanford, en EE. UU., ha revelado que entrenar modelos de IA a través de datos sintéticos parece provocar su erosión, al menos a largo plazo. El término acuñado por los académicos para indicar esta aparente ‘autoinmune’ del software es MAD, un acrónimo de Model Autophagy Disorder (trastorno de autofagia del modelo). El documento plantea serios interrogantes sobre cuál podría ser el punto débil de una práctica ya muy extendida en el ámbito del machine learning.

Los datos sintéticos son conjuntos de datos informáticos que se diferencian de los tradicionales porque se generan artificialmente y no se recopilan de forma convencional. Se crean para emular el mundo real utilizando la inteligencia artificial, y están destinados a entrenar modelos de aprendizaje automático. “Los datos sintéticos se aprovechan en el desarrollo, prueba y validación de servicios de aprendizaje automático, donde los datos reales no están disponibles en las cantidades necesarias o no existen”, explica la Agencia Española de Protección de Datos (AEPD). Este conjunto de datos puede incluir imágenes de rostros humanos inexistentes, textos escritos mediante algoritmos, datos financieros simulados, grabaciones de voz artificiales y datos meteorológicos completamente inventados. Con la proliferación de negocios relacionados con el desarrollo de la IA, la demanda de datos sintéticos está creciendo. La consultora Gartner estima que, de aquí a 2030, sustituirán en gran medida a los datos ‘reales’ en el entrenamiento de este tipo de software.

Más disponibilidad, más baratos y libres de derechos

En un mundo que requiere cada vez más información digital para desarrollar programas basados en aprendizaje automático, los beneficios de esta solución son claros. Los synthetic data no deben ser recopilados y representan un recurso óptimo para crear bases de datos muy amplias. Además, al ser completamente libres de derechos de autor o limitaciones de privacidad, permiten evitar los problemas legales enfrentados por ChatGPT y otros modelos de inteligencia artificial entrenados a partir de enormes cantidades de información disponible en línea, una práctica conocida como scraping.

En el artículo publicado por los investigadores, cinco ciclos de entrenamiento con datos sintéticos fueron suficientes para que los resultados del modelo de IA examinado “explotaran”. Según el documento, si se entrena repetidamente con este tipo de datos, la máquina comienza a extraer contenidos cada vez más convergentes y menos variados. La repetición de este proceso, explican los estudiosos, crea el ciclo ‘autofágico’ denominado MAD.

Endogamia de datos

El problema surge de lo que podría considerarse una especie de endogamia de datos, que lleva al software a resultados cada vez más insatisfactorios. De hecho, según Jonathan Sadowski, investigador de la Universidad Monash de Melbourne (Australia), estamos hablando de “un sistema que está tan entrenado en los resultados de otras IA generativas que se convierte en un mutante endogámico (…) con características exageradas y grotescas”. De ahí la analogía con la enfermedad de las vacas locas.

Además, actualmente, los conjuntos de datos utilizados para entrenar modelos generativos provienen principalmente de Internet. Por lo tanto, muchas IA ya se entrenan, sin saberlo, con cantidades cada vez mayores de datos sintetizados. Este es el caso del popular conjunto de datos Laion-5B, usado para entrenar modelos de texto-imagen de última generación, como Stable Diffusion, que contiene una mezcla de imágenes sintéticas ya muestreadas previamente por otros modelos. El riesgo es provocar un fenómeno con consecuencias exponenciales.

Su futuro, nuestra mejor inversión

Capitalice las oportunidades de forma positiva, consciente y comprometida con soluciones diseñadas para usted de la mano de nuestros expertos en inversión de su banca en Suiza.

La IA que viene

Sin embargo, es indiscutible que los datos sintéticos representan la nueva frontera de la inteligencia artificial. La relación calidad-conveniencia es incomparable, y no solo por razones económicas. A nivel de tendencias generales es previsible que en 2024 se observe un impacto significativo de la IA en la gestión de recursos humanos, con la automatización de la selección de candidatos. Será cada vez más central también para la ciberseguridad, con algoritmos capaces de detectar y neutralizar rápidamente amenazas sofisticadas.

Por otro lado, la adopción generalizada de la IA en los procesos de toma de decisiones obligará a garantizar su transparencia, con la afirmación de la llamada IA explicable (XAI) que permitirá a los usuarios comprender y confiar en los resultados generados por los algoritmos. La IA también mejorará la personalización de la experiencia de usuario, por ejemplo a través de chatbots. Finalmente, se estima que el mercado mundial de la inteligencia artificial en el ámbito de la salud alcance los 188.000 millones de dólares para 2030. La esperanza es que la tecnología pueda reducir los errores y mejorar la calidad de la atención, con un impacto positivo en la vida de las personas.

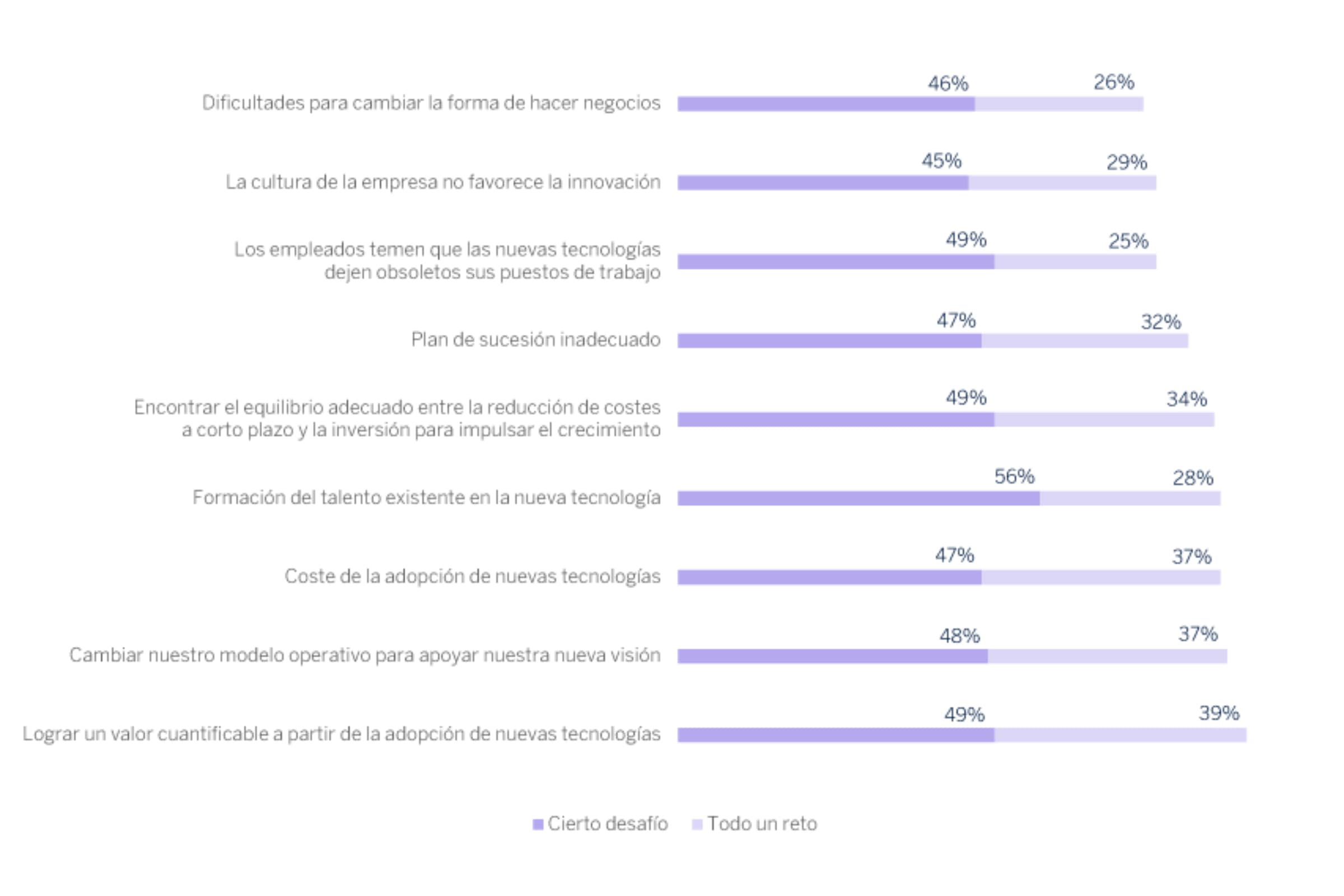

Desafíos en la transformación interna de las empresas en Estados Unidos en 2023